Trong thế giới an ninh mạng đầy biến động, một mối đe dọa mới đang nổi lên, không phải từ những hacker ẩn mình trong bóng tối, mà từ chính những công cụ trí tuệ nhân tạo (AI) mà chúng ta đang sử dụng.

Một khảo sát gần đây cho thấy, các chuyên gia an ninh mạng đang lo ngại về việc nhân viên vô tình trao quyền truy cập dữ liệu nhạy cảm cho các “điệp viên AI”. Cụ thể, 63% số người được hỏi tin rằng đây là mối đe dọa lớn nhất từ bên trong tổ chức.

Điều đáng báo động hơn, một nửa số tổ chức (50%) đã từng trải qua các sự cố an ninh mạng do AI gây ra trong vòng sáu tháng qua. Mặc dù AI mang lại nhiều lợi ích, nhưng việc quản lý lỏng lẻo có thể dẫn đến những hậu quả khó lường.

Chỉ có một phần nhỏ các nhà lãnh đạo an ninh (21%) tự tin rằng họ có thể kiểm soát hoàn toàn việc sử dụng các công cụ AI trong công ty. Đáng lo ngại hơn, gần một phần ba (32%) cho rằng một nửa số nhân viên đang sử dụng các công cụ AI trái phép, không được kiểm duyệt.

Điều này tạo ra một lỗ hổng lớn trong hệ thống phòng thủ. Hơn một nửa số người được hỏi (54%) thừa nhận rằng các chính sách quản lý AI của họ còn yếu kém. Khoảng cách giữa các công cụ AI được kiểm soát và những công cụ “ngoài vòng pháp luật” có thể lên tới 50%.

Dave Lewis, một chuyên gia tư vấn an ninh mạng, cảnh báo rằng một sự cố lớn liên quan đến AI chỉ là vấn đề thời gian. Nhân viên thường कॉपी và dán dữ liệu nhạy cảm vào các giao diện chat mà không hề đọc kỹ các điều khoản sử dụng. Điều này có nghĩa là dữ liệu của bạn có thể được sử dụng để huấn luyện các mô hình AI, và sau đó xuất hiện ở những nơi không ai có thể ngờ tới.

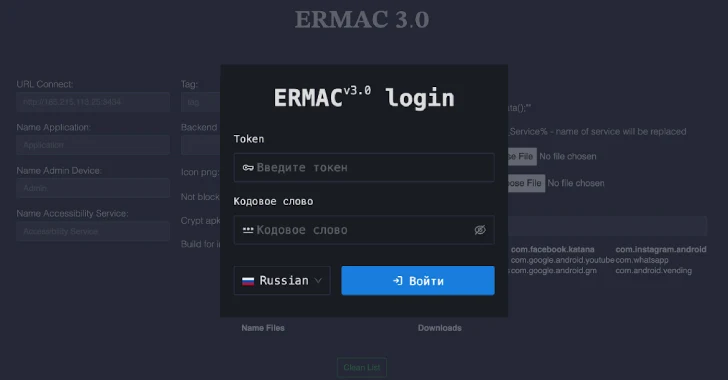

Trong cuộc chạy đua công nghệ AI, các vấn đề an ninh mạng đang bị bỏ qua. Tin tặc ngày càng sử dụng thành thạo kỹ thuật “prompt engineering” (tạm dịch: kỹ thuật điều khiển) để khai thác dữ liệu. Hàng triệu “điệp viên AI” tự động đang trở thành mục tiêu béo bở, có thể giúp tin tặc xâm nhập vào toàn bộ quy trình làm việc.

Các lỗ hổng trong công cụ AI đang được phát hiện ngày càng nhanh chóng. Ví dụ, lỗ hổng “EchoLeak” trong Microsoft 365 Copilot cho phép tin tặc đánh cắp dữ liệu nhạy cảm một cách dễ dàng.

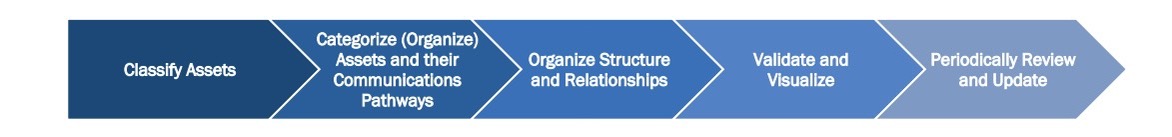

Các đội ngũ an ninh mạng cần tìm cách đảm bảo rằng nhân viên chỉ sử dụng các công nghệ AI đã được kiểm duyệt. Việc “nhốt” AI trở lại là không thể, nhưng chúng ta có thể khuyến khích nhân viên tránh xa các công cụ “đen” (shadow AI) không được bảo vệ.

Trong khi chờ đợi, hãy chuẩn bị cho tình huống xấu nhất. Rất có thể, dữ liệu nhạy cảm của bạn đã попал vào một mô hình ngôn ngữ lớn (LLM) nào đó. Điều quan trọng là phải xem xét cách dữ liệu đó có thể xuất hiện trở lại, gây ra những hậu quả khó lường.

Giải thích thuật ngữ:

- AI Agents (Điệp viên AI): Các chương trình AI tự động thực hiện các nhiệm vụ cụ thể mà không cần sự can thiệp liên tục của con người.

- Prompt Engineering (Kỹ thuật điều khiển): Kỹ thuật thiết kế các câu lệnh (prompts) để “điều khiển” các mô hình AI tạo ra kết quả mong muốn.

- LLM (Mô hình ngôn ngữ lớn): Một loại mô hình AI có khả năng hiểu và tạo ra ngôn ngữ tự nhiên ở quy mô lớn.

- Shadow AI (AI đen): Việc sử dụng các công cụ và ứng dụng AI không được phê duyệt hoặc quản lý bởi bộ phận CNTT của một tổ chức.